El próximo día 15 concluye el plazo para presentar trabajos al número especial IA generativa, ChatGPT y Educación. Consecuencias para el Aprendizaje Inteligente y la Evaluación Educativa

Hasta el día de la fecha se han presentado una treintena de envíos. Han superado la revisión previa cinco, los cuatro siguientes, y uno que ha sido desestimado. Un trabajo, además, ha superado la revisión de pares, el resto ha pasado la criba de la revisión editorial y, sin prejuzgar nada, tienen posibilidades de superar la revisión de pares.

Son:

Análisis mediante inteligencia artificial de las emociones del alumnado autista en la interacción social con el robot NAO. VV AA de Universidad de Alicante, España

Machine vs Machine: Large Language Models (LLMs) in Applied Machine Learning High Stakes Exams. VV AA Faculty of Computing, Digital and Data, TU Dublin, Dublin, Ireland.

La autorregulación del aprendizaje desde un enfoque de feedback entre pares: perspectivas de la IA generativa/Self-regulation of learning from a peer feedback approach: insights from generative AI. VV AA Universitat Oberta de Catalunya, Barcelona. España.

The use of social robots as teaching assistants in education: possibilities and threats. VV AA Universidad de Zagreb.

De entre los desestimados en la fase editorial la mayoría no

se ajustan a las condiciones de la convocatoria. Se deseaba que se presentasen

investigaciones empíricas de cómo las tecnologías y herramientas de la IA descritas

modificasen significativamente, o no, el aprendizaje y qué formas de diseño

educativo lo promovían. En ningún caso, y ante la ausencia de investigaciones

empíricas, se ha pensado en completar el número con revisiones de la literatura o con ensayos exegéticos, al menos

que no tuvieran un sustento empírico.

Citamos a modo de ejemplo los resúmenes de algunas de las rechazadas:

Todo ello nos confirma lo dicho en otros posts y preprints. En particular en el post de Hypotheses Inteligencia Artificial y Educación ¿dónde estamos?, donde, en la parte II, se dice:

En el día de hoy, revisando plataformas de edición científica

(Scopus-Elsevier, WoS, Google Scholar) no he encontrado investigaciones

rigurosas y terminantes de ventajas en el aprendizaje, no en destrezas

instrumentales como puedan ser la ayuda a la redacción, que habría que ver si

es útil para la adquisición de esa destreza o contraproducente, sino en

aspectos centrales, los que definen Merrill o Gagné como

principios principales del aprendizaje. Por el contrario, he encontrado

artículos de dudosa buena práctica investigadora, pese a haber superado la

revisión de pares. Como por ejemplo estos:

Para citar a continuación tres casos significativos que

merecen la pena si no leerse completamente sí leer la reseña.

En ese post también decíamos algo que es igualmente válido ahora:

Resumiendo, sobre esas evidencias y buenas prácticas, que no existen

prácticamente o no existen de forma consistente y fiable, estamos buscando

información. También las revistas y las instituciones públicas o de

investigación lo ven como una urgencia. En este sentido podemos señalar cinco

iniciativas.

1

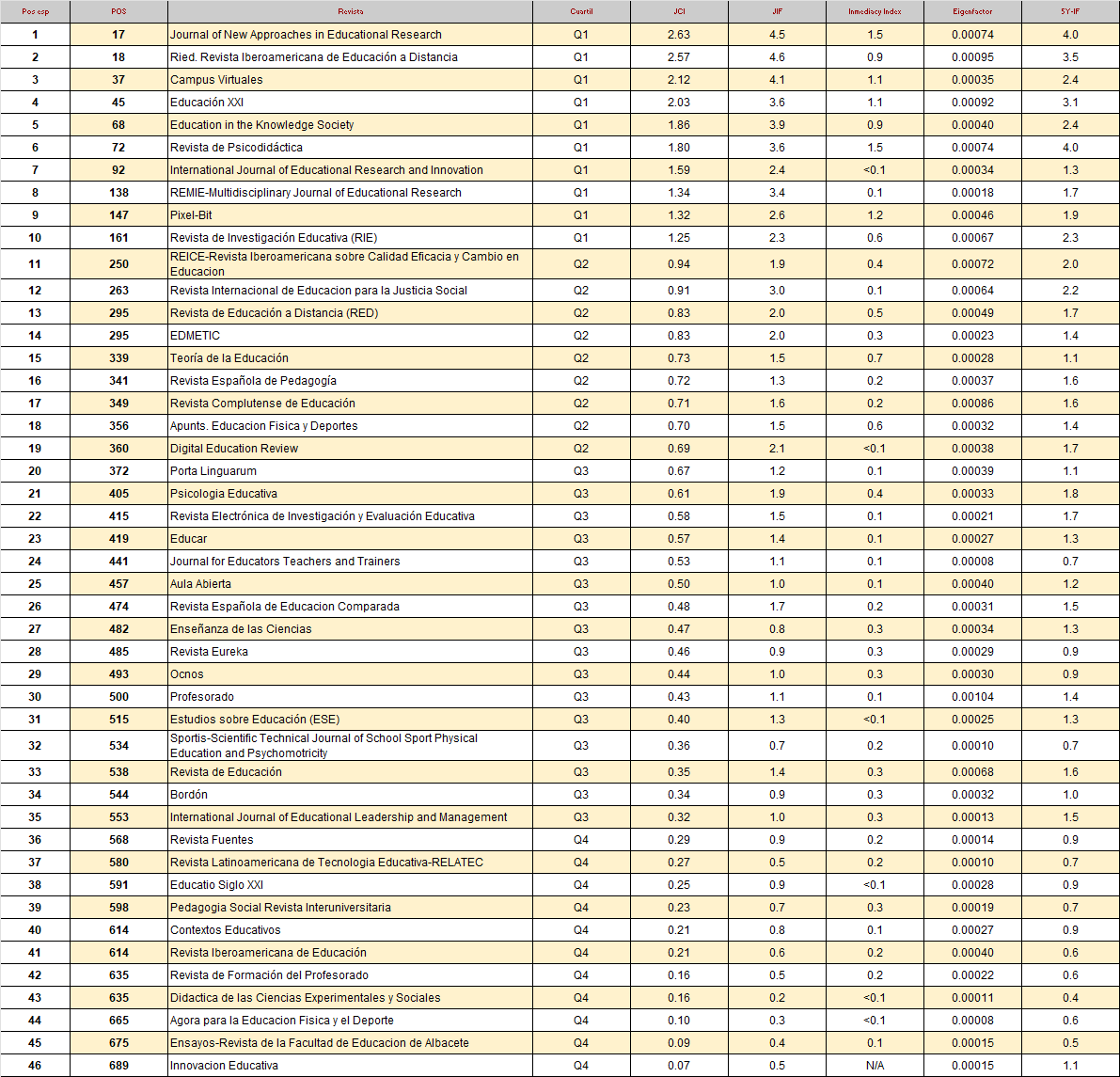

RED.

Convocatoria de un número especial titulado IA generativa,

ChatGPT y Educación. Consecuencias para el Aprendizaje Inteligente y la

Evaluación Educativa / Generative AI, ChatGPT and Education. Consequences for

Intelligent Learning and Educational Assessment. Se plantean las consecuencias frente a

dos posibles escenarios y sus consecuencias. El primero se derivan de que la IA

tenga el potencial de revolucionar los métodos de enseñanza, la evaluación y la

ayuda al alumno, existentes. El segundo el que la IA tenga la capacidad de

crear un sistema educativo completamente nuevo.

Otras cuestiones que se plantean

ahora como interrogantes son: Cuáles son los impactos que se producirán cuando

la IA comience a servir como un socio activo en acciones sociales, creativas e

intelectuales sostenidas a lo largo del tiempo, no sólo puntuales o como

repuesta a preguntas aisladas, que es lo que ahora más frecuentemente se hace.

En este momento esos impactos en las prácticas, los que puedan existir, son

desconocidos. También se plantgea cómo del impacto de una dependencia excesiva,

en los sistemas de IA en la educación, se podría derivar una disminución de

muchos de los rasgos que nos hacen humanos. En este caso la pregunta es si ese

impacto contribuiría a una disminución de la formación “humana” de los alumnos.

Entre esos rasgos se incluyen la autorregulación, la metacognición, la

orientación a objetivos, la planificación, las tormentas de ideas creativas y

una variedad de habilidades que podrían verse afectadas negativamente por la

automatización o la toma de control de las máquinas.

2

Computers and

Education: Artificial Intelligence. Special issue

Exploring the Nexus of Generative AI and Language Education: Opportunities,

Challenges, and Innovations, es la Segunda iniciativa

3

International Journal of

Educational Technology in Higher Education (IJ of ETHE). Especial interés tiene el caso de New advances in

artificial intelligence applications in higher education ,

que inicialmente entendí que se convocó como un número especial de ETHE y ahora

es una colección de artículos, pero con un artículo solo, porque la recepción

de originales se cerró.

El único trabajo aceptado, AI-generated feedback on writing: insights into efficacy and ENL student preference, consta de dos interesantes estudios longitudinales, el segundo de los cuales es un self report study sobre el primero, pero más que propiamente un análisis sobre aprendizaje es sobre evaluación. Ésa es la única conclusión en sentido positivo, las otras son que no se pueden establecer preferencias claras.

4

UK Generative AI in

education Call for Evidence: summary of responses. El Departamento de Educación lanzó en verano pasado

(para recoger datos entre el 14 de junio y el 23 de agosto de 2023) una

Convocatoria de Evidencia sobre el uso de Inteligencia Artificial Generativa

(GenAI) en educación. Solicitaba opiniones y experiencias de profesionales de

todas las etapas de la educación, así como del sector de tecnología educativa

(EdTech), se refiere al sector de investigación, y a expertos en inteligencia

artificial (IA). En este caso no se trata de lanzar solo una convocatoria sino

de recoger lo que ya existe en la práctica y en la investigación.

Las respuestas que se obtuvieron,

y sobre las cuales se abre una fase de evaluación, revelaron una amplia gama de

usos de la tecnología GenAI con fines educativos.

Para un posterior análisis, las

aplicaciones identificadas entre los docentes se han agrupado en los siguientes

siete temas clave según los casos de uso:

- Creación de recursos educativos

- Planificación de unidades y planes de estudios

- Uso “en vivo” en las lecciones

- Evaluación, calificación y retroalimentación

- Tareas administrativas

- Capacitación en habilidades GenAI y alfabetización en IA.

- Investigación

5

El British Journal of

Educational Technology publica en septiembre de 2023 una sección especial en

su número orinario, fechada en mayo de este año, con el título, que

también recibe el editorial, Advancing theory in the age of

artificial intelligence. Son diez artículos que se explican

en el editorial, así como las conclusiones, que utilizaremos en este trabajo.

Sus autores y editores son Dawson, Joksimovic, Mills, Gašević y

Siemens. Destacamos que Gašević es también editor del especial

de Computers and Education: Artificial Intelligence, reseñado en primer

lugar y del trabajo que también reseñamos sobre la vigencia del aprendizaje

humano por refuerzo.

Esperemos que estas iniciativas nos den como

resultado el panorama real de la investigación y de lo evidenciado sobre GenA,

LLM y ChatGPT y su influencia en el aprendizaje de los alumnos.

Fin de la cita.

La ausencia de investigaciones lleva a autores como Donal Clark

a mencionar como ejemplo un artículo, supongo

que como respuesta a los que pedimos pruebas. Compartió

en un tuit un artículo

de una supuesta rigurosa investigación. En el post textualmente dice “las explicaciones basadas en LLM

impactaron positivamente el aprendizaje”.

Pero, si nos vamos a las conclusiones del artículo ya expuestas

desde el abstract, lo que establecen es que “la exposición a explicaciones de

LLM aumentó la cantidad de personas que SENTÍAN QUE HABÍAN APRENDIDO y

disminuyó la DIFICULTAD PERCIBIDA de los problemas del test.”

Es lo que decimos: no hay evidencias clara, hasta ahora, sobre

IA generativa y aprendizaje, solo self report studies y

revisiones de exégesis de revisiones de literatura, que se multiplican y

aumentan citas e impacto ad nauseam.

Tres de los cuatro autores son de Microsoft Research ¿Casualidad?

Se trata de un preprint (Kumar, Rothschild,

Goldstein and Hofman, November 22, 2023) de la prestigiosa plataforma SSRN de

Elsevier.

Para no ser totalmente pesimista habría que reseñar lo que se

dice en el apartado III del post de Hypotheses,

hay una esperanza en campo de las practicas con genAI y las conclusiones que de

ahí se obtienen. En ese sentido citábamos el trabajo de Korinek

(2023), que no sería un trabajo muy

importante si no fuera porque no hay muchos otros. Es el único empírico que he

podido localizar.

Básicamente, según el propio autor, en él “informa de su

calificación subjetiva sobre qué tan útiles encontró las capacidades LLM

descritas al 1 de febrero de 2023”. Se refiere a las prácticas que él mismo

hizo y con las que elaboró un estudio personal de 25 casos de uso de ChatGPT en

25 prácticas que él hizo y su opinión sistematiza en categorías sobre ellas.

Sobre esa propuesta, quien suscribe ha hecho otra, tomándola

como referencia.

Pero volviendo al tema inicial, cabe decir que quienes quieran

contraargumentar estas ideas y conclusiones, al margen de que por ser de

urgencia son incompletas y posiblemente con fallos, lo mejor que podrían hacer

es demostrar el movimiento andando y poner en marcha investigaciones

consistentes evidenciando lo que los LLM y la genAI puede ayudar al aprendizaje

y en la Educación.

Da poco tiempo para registrar contribuciones en RED, pero si no

hay suficientes o si alguien lo demanda para registrarlas, ampliaremos el plazo

de recepción de originales.

REFERENCIAS

Korinek, A. (2023). Language models and cognitive automation for economic research (No. w30957). National Bureau of Economic Research.

Kumar, Harsh and Rothschild, David M. and Goldstein, Daniel G. and Hofman, Jake (November 22, 2023). Math Education with Large Language Models: Peril or Promise? SSRN preprintAvailable at SSRN: https://ssrn.com/abstract=4641653 or http://dx.doi.org/10.2139/ssrn.4641653

Merrill, M. D. (2002a). First principles of instruction. Educational technology research and development, 50(3), 43-59. http://csapoer.pbworks.com/f/First+Principles+of+Instruction+(Merrill,+2002).pdf

Merrill, M. D. (2012). First principles of instruction. John Wiley & Sons.

Merrill, M. D. (1991). Constructivism and instructional design. Educational technology, 31(5), 45-53.

Merrill, M. D. (2002b). First principles of instruction. Educational Technology Research and Development, 50(3), 43-59. Instructional-Design Theories and Models, Volume III: Building a Common Knowledge Base.

Merrill, M. D. (2009). First Principles of Instruction. In C. M. Reigeluth & A. Carr (Eds.), Instructional Design Theories and Models: Building a Common Knowledge Base (Vol. III). New York: Routledge Publishers.

.webp)